自动运行批量AI机器学习训练,开发资源效益最大化

时间:2024-05-31

在人工智能(AI)和机器学习(ML)的时代,企业和研究机构正在加速拥抱这些变革性技术。然而,AI/ML模型的训练往往是一个耗时且资源密集型的过程,特别是当涉及到大规模的批量训练任务时。如何在提高开发效率的同时,最大化资源利用率?InfinitiesSoft的AI-Stack平台为这一难题提供了解决方案。

AI/ML模型训练面临的挑战

AI/ML模型的训练通常涉及以下几个关键步骤:

- 1、数据准备和预处理

- 2、模型设计和实现

- 3、超参数调整和模型优化

- 4、模型评估和验证

这个过程不仅耗时,而且经常需要多轮迭代和实验,以找到最优的模型配置。此外,不同的训练任务可能需要不同的计算资源(如CPU、GPU、内存等),这对资源的调度和管理提出了更高的要求。

传统的做法是手动创建和管理训练环境,并逐个运行训练任务。这种方式不仅效率低下,而且容易导致资源浪费。例如,当一个训练任务完成后,相应的计算资源(如GPU)可能会闲置,直到下一个任务开始。

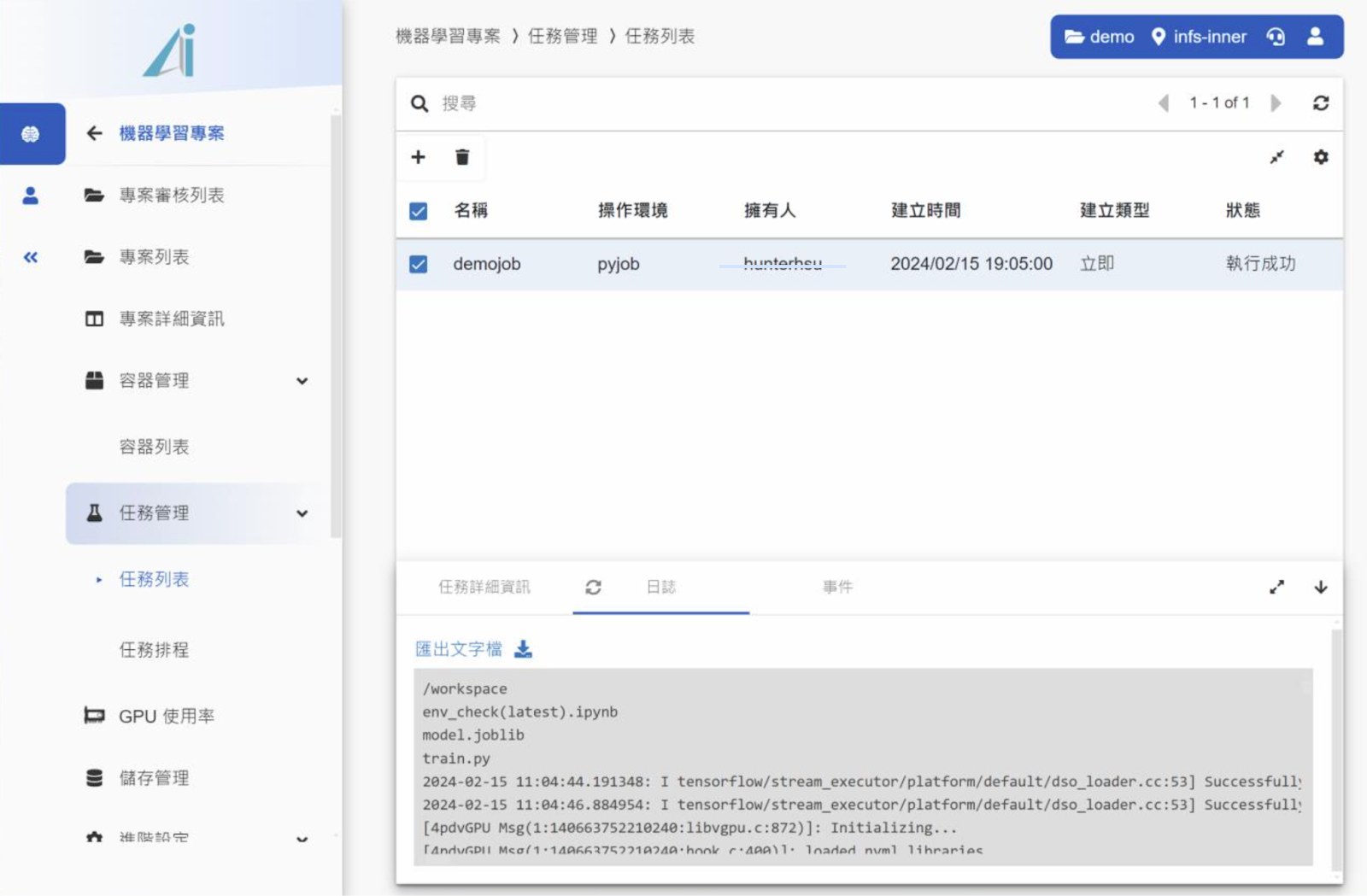

AI-Stack的任务管理功能

为了应对这些挑战,AI-Stack平台引入了强大的任务管理功能,帮助用户自动化和优化AI/ML训练流程。

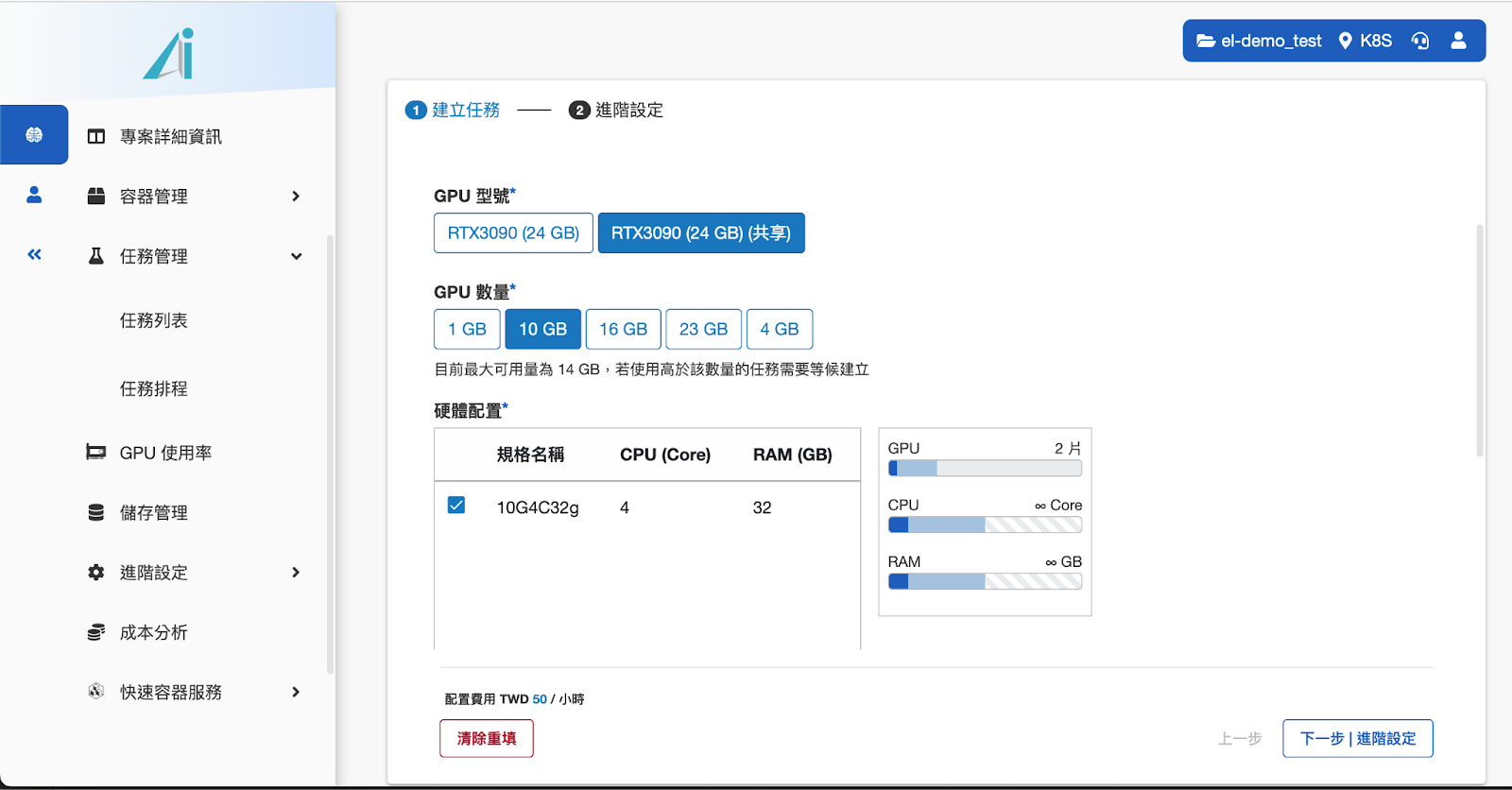

任务型容器

AI-Stack允许用户创建特殊的“任务型容器”。与普通的开发环境容器不同,任务型容器是专为运行特定的训练任务而设计的。用户可以在创建容器时指定要运行的命令(如Python脚本或Shell脚本),以及所需的计算资源(如CPU、GPU数量和类型)。

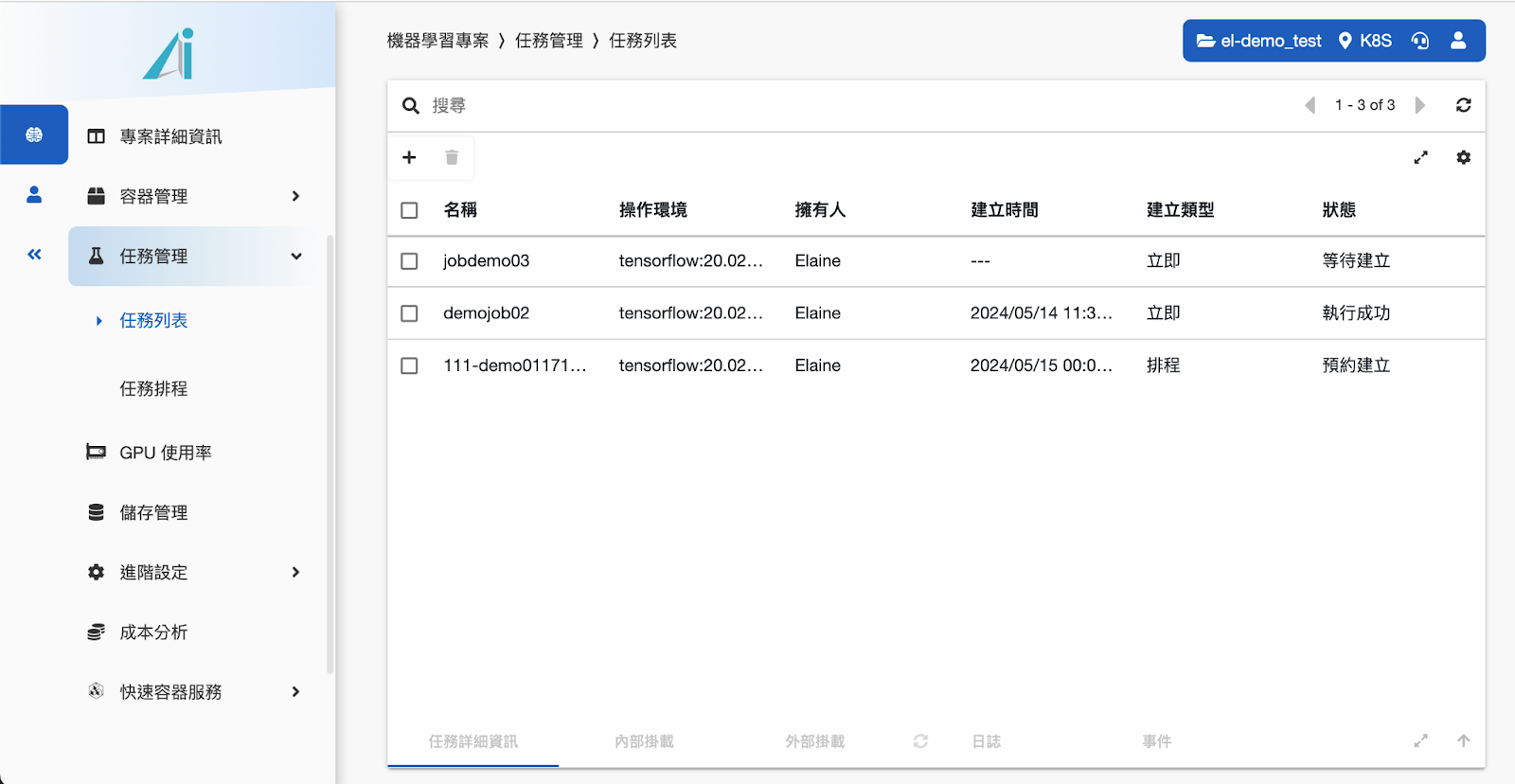

任务调度与批量运行

创建任务型容器后,用户可以将其提交到AI-Stack的任务队列中。AI-Stack的调度器会根据任务的优先级和资源需求,自动分配适当的计算资源,并在合适的时间启动容器运行任务。

通过这种方式,多个训练任务可以批量提交和运行,无需用户手动干预。AI-Stack会自动管理容器的生命周期,在任务完成后自动销毁容器,释放计算资源供其他任务使用。

无人值守的自动化训练

任务型容器的另一个关键优势是支持无人值守的自动化训练。传统的训练流程通常需要用户手动启动训练脚本,并监控训练进度。而使用AI-Stack,用户只需提交任务,平台会自动创建容器、运行预定义的命令,并在训练完成后自动清理资源。

这种自动化不仅省去了用户的手动操作,还可以实现24/7不间断的训练,充分利用夜间和周末的计算资源,从而大大加快训练进度。

客户收益

通过采用AI-Stack的任务管理功能,客户可以获得显著的收益:

- 1、加速模型开发:自动化的批量训练可以显著减少模型开发和优化的时间,让数据科学家能够更快地迭代和验证想法。

- 2、提高资源利用率:通过自动调度和动态分配计算资源,AI-Stack可以最大限度地利用可用的CPU和GPU,避免资源闲置浪费。据估计,资源利用率可提高30%以上。

- 3、降低人力成本:无人值守的自动化训练可以极大地减少人工干预,节省宝贵的人力资源。数据科学家可以将更多的时间投入到内核的算法研究和模型创新上。

- 4、强化训练能力:借助AI-Stack的弹性扩展能力,客户可以轻松应对大规模训练任务,而无需担心基础设施的限制。

结论

AI-Stack的任务管理功能是企业和研究机构进行AI/ML模型训练的利器。它通过自动化的批量训练和无人值守的运行,显著提升了开发效率和资源利用率。客户可以专注于内核的AI/ML创新,而将繁琐的环境管理和任务调度交给AI-Stack处理。

如果您的企业正在寻求高效、经济的AI/ML训练解决方案,不妨尝试AI-Stack平台。让我们携手释放AI/ML的潜力,加速您的业务创新!